El procesamiento y análisis de grandes volúmenes de datos es esencial en la actualidad, y Hadoop ha emergido como una solución robusta para empresas que manejan Big Data. Este marco de software permite el almacenamiento distribuido y el procesamiento eficiente de datos en varios servidores, ofreciendo escalabilidad y fiabilidad. Este artículo aborda en profundidad qué es Hadoop, sus componentes, evolución, y cómo se compara con otras herramientas como Spark.

¿Qué es Hadoop?

Definición de Hadoop

Hadoop es un software de código abierto creado para el procesamiento distribuido de grandes volúmenes de datos. Este sistema permite almacenar y procesar datos en un clúster de servidores, gestionando fallos y asegurando la disponibilidad del sistema mediante la distribución de copias de los datos. Hadoop fue desarrollado por la Apache Software Foundation y está diseñado para trabajar de forma eficiente con datos dispersos en múltiples servidores.

Este marco es utilizado principalmente para el análisis de grandes volúmenes de datos, permitiendo que diversas organizaciones puedan extraer información valiosa de estos datos a través de un proceso eficiente y escalable.

Historia y evolución

La creación de Hadoop se remonta a 2005, cuando Doug Cutting y Mike Cafarella desarrollaron el software como parte del proyecto Nutch, un motor de búsqueda distribuido. La tecnología que dio lugar a Hadoop se basó en el modelo MapReduce de Google, lo que permitió que el procesamiento de datos pudiera realizarse de manera distribuida, con miles de nodos trabajando en conjunto.

Hadoop ha evolucionado significativamente desde su creación. En sus primeros años, fue adoptado por grandes empresas tecnológicas como Yahoo!, que lo implementó en 2006 para gestionar grandes cantidades de datos en sus servidores. Actualmente, Hadoop se utiliza en múltiples industrias, desde el sector financiero hasta la salud, debido a su capacidad para procesar grandes volúmenes de datos con flexibilidad y tolerancia a fallos.

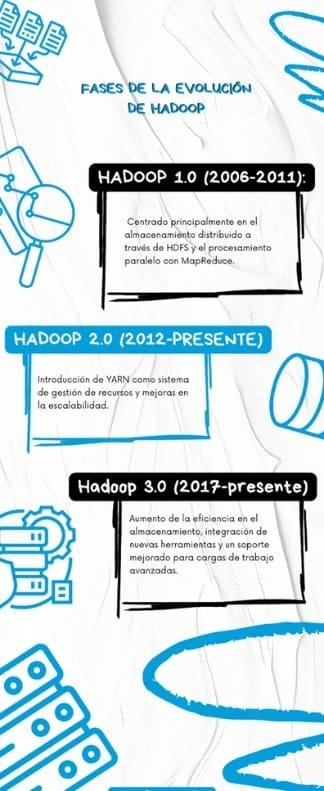

Fases de la evolución de Hadoop:

Principales componentes de Hadoop

Hadoop Distributed File System (HDFS)

El Hadoop Distributed File System (HDFS) es uno de los componentes más críticos de Hadoop. Es un sistema de archivos distribuido que permite almacenar grandes cantidades de datos a través de varios servidores, garantizando la tolerancia a fallos mediante la replicación de los datos en diferentes nodos. Si un nodo falla, HDFS asegura que los datos aún estén disponibles en otro nodo.

MapReduce

MapReduce es el modelo de programación que permite a Hadoop procesar grandes volúmenes de datos en paralelo. Divide las tareas de procesamiento en dos fases: Map, que distribuye las tareas a diferentes nodos, y Reduce, que agrupa y resume los resultados obtenidos. Este modelo ha demostrado ser eficiente para procesar datos distribuidos.

YARN

YARN (Yet Another Resource Negotiator) es el sistema de gestión de recursos de Hadoop. Es responsable de asignar recursos a las diferentes aplicaciones que se ejecutan en el clúster y permite que Hadoop maneje múltiples tareas de procesamiento al mismo tiempo.

Hadoop Common

Este módulo proporciona las bibliotecas y utilidades necesarias para que los otros componentes de Hadoop interactúen y funcionen correctamente. Incluye todas las herramientas comunes que se requieren para el funcionamiento del clúster.

Ventajas del uso de Hadoop en Big Data

Hadoop se destaca por su capacidad de manejar grandes volúmenes de datos distribuidos, pero además de su escalabilidad, tiene otras ventajas que lo convierten en la solución preferida para muchas organizaciones.

Escalabilidad y procesamiento distribuido

Hadoop permite escalar de manera horizontal añadiendo nodos adicionales al clúster según se incrementen los volúmenes de datos, lo que facilita su uso en empresas que manejan grandes cantidades de datos. A través de la arquitectura distribuida de Hadoop, es posible procesar los datos en paralelo en todos los nodos del clúster, mejorando el rendimiento y reduciendo los tiempos de procesamiento.

Flexibilidad y almacenamiento masivo

Una de las mayores fortalezas de Hadoop es su capacidad para almacenar datos de diferentes formatos. No solo puede manejar datos estructurados, sino que también puede almacenar datos no estructurados como imágenes, vídeos o archivos de texto. Esta flexibilidad permite a las organizaciones trabajar con datos diversos sin la necesidad de transformarlos o preprocesarlos.

Casos de uso de Hadoop en la industria

- Finanzas: Las instituciones bancarias usan Hadoop para la detección de fraudes y la creación de modelos de análisis de riesgos. Con la capacidad de procesar datos en tiempo real, los bancos pueden identificar actividades sospechosas en cuestión de segundos.

- E-commerce: En plataformas de comercio electrónico, Hadoop ayuda a procesar datos de clientes y sus compras para ofrecer recomendaciones personalizadas y mejorar la experiencia de usuario.

- Sector sanitario: Hadoop se utiliza para gestionar grandes volúmenes de datos médicos, desde historiales clínicos hasta estudios genéticos, lo que permite mejorar los diagnósticos y los tratamientos personalizados.

Comparativa con otros sistemas: Hadoop vs. Spark

Aunque Hadoop es una herramienta sólida, Apache Spark ha ganado popularidad debido a su capacidad para realizar procesos más rápidos. A continuación, se presenta una comparativa entre ambos sistemas.

| Característica | Hadoop | Spark |

| Modelo de procesamiento | MapReduce (en disco) | Procesamiento en memoria |

| Velocidad | Lento en procesamiento iterativo | Rápido, especialmente en análisis en tiempo real |

| Facilidad de uso | Requiere más esfuerzo | Interfaz más amigable |

| Compatibilidad con HDFS | Totalmente integrado | Integración opcional |

| Casos de uso principales | Procesamiento por lotes, almacenamiento masivo | Procesamiento en tiempo real, machine learning |

| Tolerancia a fallos | Alta, basada en la replicación de datos en HDFS | Alta, basada en DAG (Directed Acyclic Graph) |

Hadoop vs Spark: ¿Cuál elegir?

La elección entre Hadoop y Spark depende de las necesidades específicas de cada organización. Si una empresa requiere un sistema principalmente para el almacenamiento masivo y el procesamiento por lotes, Hadoop es la opción ideal. Sin embargo, si se necesita un procesamiento más rápido y en tiempo real, Spark es más adecuado.

Conclusión

Hadoop ha transformado la manera en que las organizaciones gestionan y procesan grandes volúmenes de datos. Su arquitectura distribuida y escalable, junto con la capacidad de almacenar y procesar datos de diversos formatos, lo convierte en una herramienta imprescindible para el análisis de Big Data.

A pesar de la competencia de alternativas como Apache Spark, Hadoop sigue siendo una solución líder en el mercado. Su evolución continua y su flexibilidad para adaptarse a diferentes necesidades lo posicionan como una de las mejores opciones para el almacenamiento distribuido y el procesamiento masivo de datos.

El futuro de Hadoop parece prometedor, especialmente en un mundo donde los datos crecen exponencialmente y la demanda por su procesamiento eficiente continúa aumentando.

Preguntas frecuentes sobre Hadoop

1. ¿Qué es Hadoop y para qué se utiliza?

Hadoop es un framework de código abierto diseñado para almacenar y procesar grandes volúmenes de datos de manera distribuida. Su principal uso es en el análisis de Big Data, ya que permite gestionar datos distribuidos en varios servidores de manera eficiente. Gracias a su arquitectura escalable, Hadoop es utilizado por empresas que manejan grandes cantidades de datos, como bancos, plataformas de e-commerce y compañías tecnológicas, para obtener insights valiosos y tomar decisiones más informadas.

2. ¿Cómo funciona Hadoop para procesar grandes volúmenes de datos?

Hadoop utiliza un sistema de procesamiento distribuido donde los datos se dividen en pequeños bloques y se distribuyen en diferentes nodos de un clúster. Su sistema de archivos, HDFS, garantiza la tolerancia a fallos mediante la replicación de los datos. El modelo MapReduce permite el procesamiento paralelo de estos datos, dividiendo las tareas en fases «Map» y «Reduce», lo que mejora el rendimiento y reduce los tiempos de análisis, incluso con conjuntos de datos masivos.

3. ¿Cuál es la diferencia entre Hadoop y Spark?

La principal diferencia radica en el modelo de procesamiento. Hadoop utiliza MapReduce, que procesa los datos en disco, lo que puede ser más lento en ciertos casos. Por otro lado, Spark realiza el procesamiento en memoria, lo que lo hace más rápido para tareas de análisis en tiempo real y aprendizaje automático. Spark es ideal para aplicaciones que requieren baja latencia, mientras que Hadoop es preferido para almacenamiento masivo y procesamiento por lotes.

4. ¿Cuáles son las ventajas de usar Hadoop en Big Data?

Hadoop ofrece varias ventajas clave:

- Escalabilidad: Es capaz de escalar horizontalmente añadiendo nodos al clúster.

- Tolerancia a fallos: HDFS replica los datos en varios nodos para prevenir la pérdida de información.

- Flexibilidad: Almacena datos de diferentes formatos, incluyendo estructurados, no estructurados y semiestructurados.

- Coste reducido: Al ser un sistema de código abierto, es más accesible para muchas empresas.

5. ¿Qué componentes forman parte de Hadoop?

Hadoop tiene cuatro componentes principales:

- HDFS (Hadoop Distributed File System): Sistema de archivos distribuido que almacena grandes volúmenes de datos.

- MapReduce: Modelo de programación para el procesamiento paralelo.

- YARN: Administrador de recursos del clúster.

- Hadoop Common: Bibliotecas necesarias para que los otros módulos funcionen correctamente.

Si te interesa aprender y formarte en profundidad en análisis de datos ¡Podemos ayudarte! En Pontia disponemos de nuestros Máster en Data Analytics, Máster en Data Science y Máster en Data Analytics y Science ( Doble titulación) dónde aprenderás Business Intelligence, Python para análisis y ciencia de datos, Machine learning, y todo lo que necesitas para convertirte en un data analyst o data scientist clave para cualquier empresa tecnológica.

Si te ha gustado este artículo y estás interesado en el mundo del análisis de datos, te invitamos a que descargues nuestra guía de Power BI. ¡Es totalmente gratis! También puedes visitar nuestro blog para descubrir más artículos como este.